研究生周一剑基于深度学习的地震震相自动识别算法论文发表于Seismologica Research Letter

地震信号的自动识别与震相拾取是地震数据的处理的基本操作之一,其识别准确率与拾取精度决定了地震定位与活动性分析的质量。这个波形检测的过程传统上常由人工完成,而近年来,随着地震观测水平的提升,海量的观测数据都需要进行震相筛选工作。这催生了自动化处理算法的需求,并对其运算效率和准确率提出了较高的要求。

传统的自动化算法主要分为长短时窗法(short-term average over long-term average, STA/LTA)与模板匹配法(matched filter technique, MFT)。长短时窗法通过检测地震记录中的能量脉冲来检测地震信号。这种方法容易受到噪声的干扰:尤其是人类活动等原因引起的脉冲型信号会使其产生大量的误识别。模板匹配算法通过互相关衡量两个信号的相似程度进行地震识别,可以适用于信噪比较低的情形。但是该算法的检测能力依赖于模板事件的完备性,一套不完备的模板事件会使结果产生偏差;另一方面,互相关的运算较为低效,大量的模板意味着大量的运算时间。因此,这两种基于数学判据的方法在地震数据处理中难以兼顾准确性与高效性。

随着人工智能的发展,深度学习算法在图像分类、语音识别以及自然语言处理等任务中表现出可以媲美人类专家的分类能力。深度学习算法是数据驱动的算法,与地球物理学常用的模型驱动的算法不同。该算法不需要人工进行判据的数学描述,而是通过大量已知的数据“训练”未知的“神经网络”参数。经过大量数据的训练得到的神经网络往往能够达到媲美人工识别的精度,且计算效率远高于人工操作。总结而言,数据驱动的算法特别适合于:“经验易掌握,模型难构建”的问题。而地震学中的震相标识正是这样的一个问题。

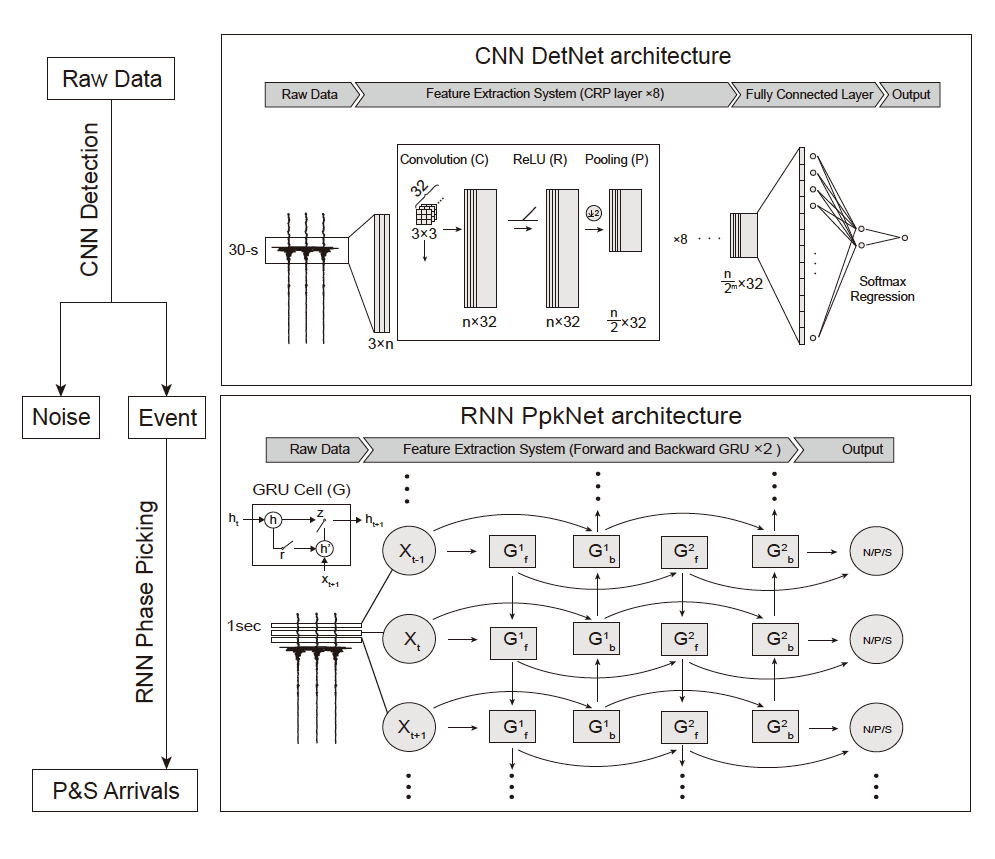

数据驱动的方法为我们解决震相标识问题提供了另一种思路: 借助大量具有人类标注的数据,通过训练深层神经网络自动提取其中的统计特征,使神经网络具备标注未知数据的能力。传统深度学习算法包括卷积神经网络(convolutional neural network, CNN)以及递归神经网络(recurrent neural network, RNN)。 CNN具备空间平移,缩放不变形,特别适合处理图像的识别。而RNN在处理过程中考虑了信号的因果性,适合语音识别问题。而地震信号同时具有两方面的特点。(图1)

图1. 用CNN和RNN分别进行地震和震相拾取的神经网络结构。

将三分量(ENZ channel)的地震信号类比于图像中的颜色,可以用CNN处理;而信号中的时间先后信息:如P波在S波之前到达,波形开始是突变信号而结束是渐变信号的时序特点也是人工标识重要的依据,适合用RNN描述。受此启发,我们将地震信号的识别问题类比为图像的识别,并训练了卷积神经网络进行地震信号与噪声样本的分类;将震相的拾取类比为语音序列的标注问题,并训练了递归神经网络进行地震信号的逐秒标注。将识别网络与拾取网络结合起来,我们可以直接从原始的连续波形中获取地震信号的P、S波到时信息。

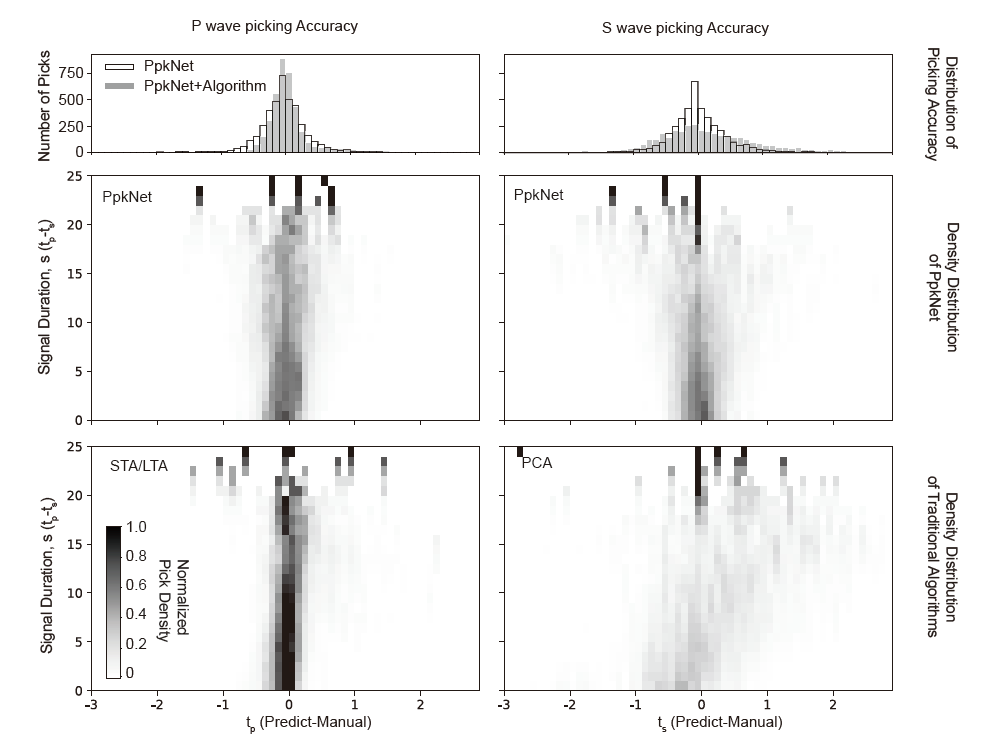

基于2017年阿里巴巴与中国地震局地球物理研究所联合举办的“汶川余震捕捉大赛”的数据,在汶川余震序列的案例中,我们使用两万余条有人工标注P、S波到时的地震数据训练神经网络,在地震识别问题中对地震和噪声样本分别达到了约为94% 和98% 的识别准确率;在震相拾取问题中,对P波与S波分别达到-0.03±0.48s和0.03±0.56s(均值±标准差)的拾取精度。相比于传统的基于长短时窗的算法,识别网络对噪声样本具有较高的识别准确率,这将在后续的活动性成像中引入更少的噪声;拾取网络在震相拾取中具有更高的稳定性,且对S波的拾取有更高的精度。(图2)

图2. P波和S波的识别精度随着震中距(PS波倒时差tp-ts)的变化。 上图为时间域积分结果,中图为CNN+RNN识别结果,下图为传统算法。

该工作由岳汉和周仕勇教授课题组合作,研究生周一剑主要完成。该方法基于Tensorflow的程序包实现已在github上开源:https://github.com/YijianZhou/CDRP_TF。 该论文于2019年发表于美国地震学会刊物Seismological Research Letters 上。

Zhou, Y., Yue, H., Kong, Q., & Zhou, S. (2019). Hybrid event detection and phase‐picking algorithm using convolutional and recurrent neural networks. Seismological Research Letters, 90(3), 1079-1087. https://doi.org/10.1785/0220180319